LLM의 한계와 대안 모델: AI 진화의 다음 단계 | 매거진에 참여하세요

LLM의 한계와 대안 모델: AI 진화의 다음 단계

#LLM모델 #한계 #대안 #장점 #단점 #융합 #진화

2023년 이후 생성형 AI와 대형 언어 모델(LLM)은 혁신의 아이콘으로 자리 잡았다.

GPT, LLaMA, Mistral 등 대형 모델은 자연어 이해와 생성 능력을 극적으로 향상시켰고, 다양한 산업에 빠르게 적용되었다.

하지만 2025년 현재, LLM 구조 자체의 한계가 점점 명확해지고 있다.

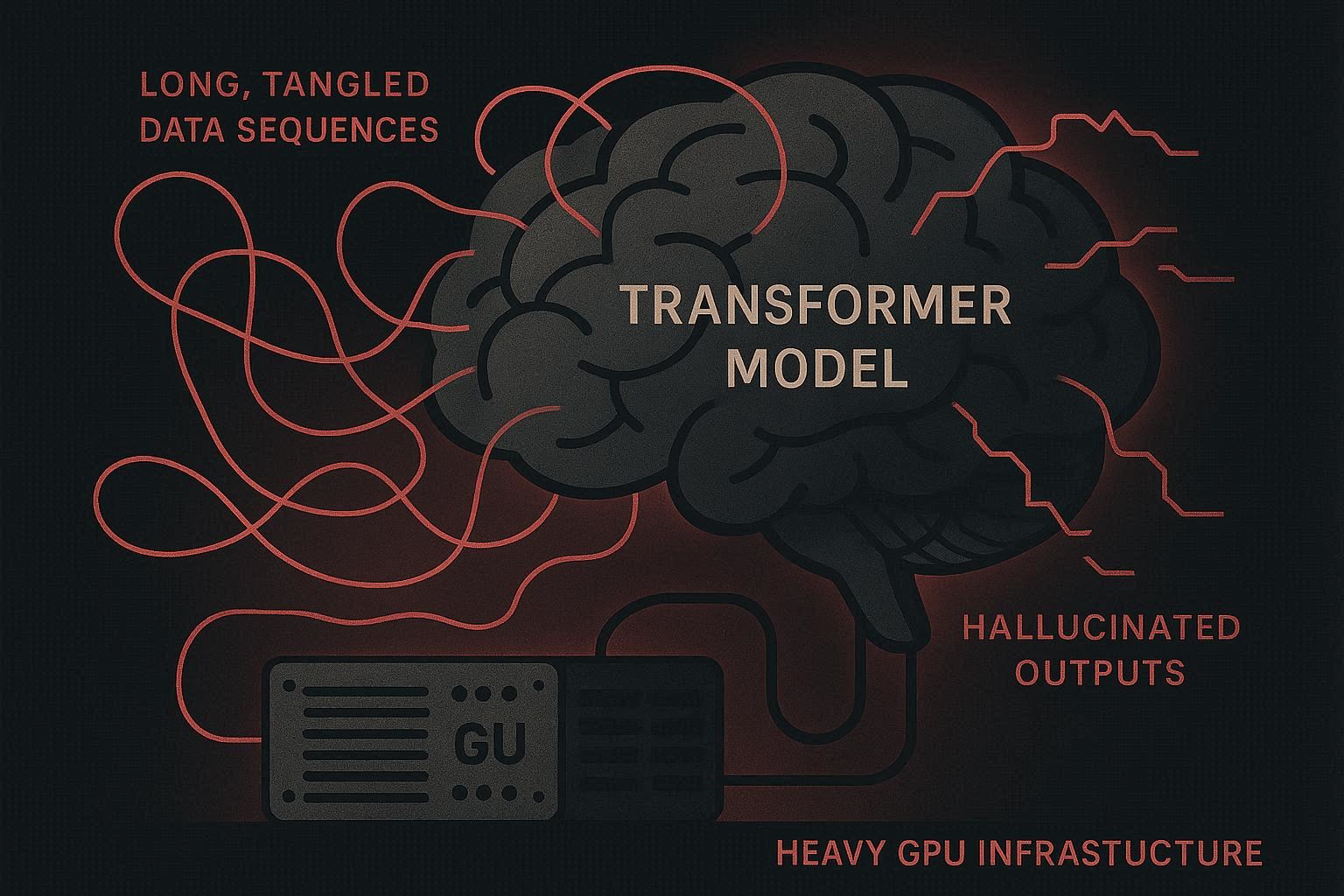

Transformer 기반의 자기회귀적 구조는 장기 추론, 복잡한 계획, 멀티모달 이해에 제한적이다.

모든 지식을 학습 데이터에 내장해야 하는 구조적 부담 → 환각(Hallucination)과 최신 정보 반영 어려움 발생.

초대형 모델은 연산량과 환경 비용 부담이 막대해 지속적인 확장에 한계가 있다.

즉, LLM은 강력하지만, 단독으로 모든 AI 문제를 해결할 수 없는 구조적 한계를 가진 셈이다.

LLM의 구조적 한계 분석

(1) 장기 추론과 계획 능력 부족

Transformer 구조는 토큰 단위로 문맥을 처리

긴 시퀀스에서 정보 손실, 추론 오류 발생

복잡한 업무 플로우, 수학·과학 계산 등 장기적 논리에는 취약

(2) 환각과 사실 검증 한계

학습 데이터 기반 통계적 예측 → 없는 정보를 생성 가능

사실 검증 기능 없음 → 기업 환경에서는 위험 요소

외부 지식 연동 없이는 최신 정보 반영 어려움

(3) 멀티모달 처리 제한

기존 LLM은 대부분 텍스트 중심

이미지, 음성, 영상 등과 결합 시 모델 설계 복잡성 증가

AI 에이전트 서비스 구현에는 한계 존재

(4) 비용과 연산 문제

수십억~수천억 파라미터 모델 → GPU/TPU, 전력, 냉각 비용 급증

스타트업과 중소기업이 자체 구축하기 어려움

환경적 부담 → 지속가능성 문제

대안 모델 접근 : LLM 구조 한계를 극복하기 위해, 여러 대안 모델이 연구·개발되고 있다

(1) 하이브리드 AI

LLM + 심볼릭 AI(규칙 기반, 지식 그래프) 결합

장점: 논리적 추론 강화, 환각 감소, 장기 계획 가능

예시: IBM Project Debater, Neuro-Symbolic AI 프로젝트

(2) 모듈형/에이전트 AI

LLM을 중심 제어기로 하고, 각 업무별 모듈 결합

장점: 멀티태스크 수행, 업무 특화, 확장 용이

예시: AutoGPT, BabyAGI, Microsoft Copilot

(3) 효율적 파라미터 모델

LLaMA, Mistral 등 소형화 LLM → 비용·연산 효율 높임

장점: 스타트업·중소기업 활용 용이, 지속적 확장 가능

(4) Retrieval-Augmented Generation (RAG)

LLM이 모든 지식을 내장하지 않고, 외부 DB/검색 활용

장점: 실시간 정보 반영, 환각 감소, 모델 크기 축소 가능

예시: LangChain + LLM, OpenAI Retrieval Plugin

(5) 멀티모달 모델

텍스트, 이미지, 음성, 영상 통합 처리 가능

예시: GPT-4V, DeepMind Gemini, Mistral Mixtral

LLM이 아닌 완전한 대안 모델 : LLM 구조가 아닌 AI 접근도 존재한다.

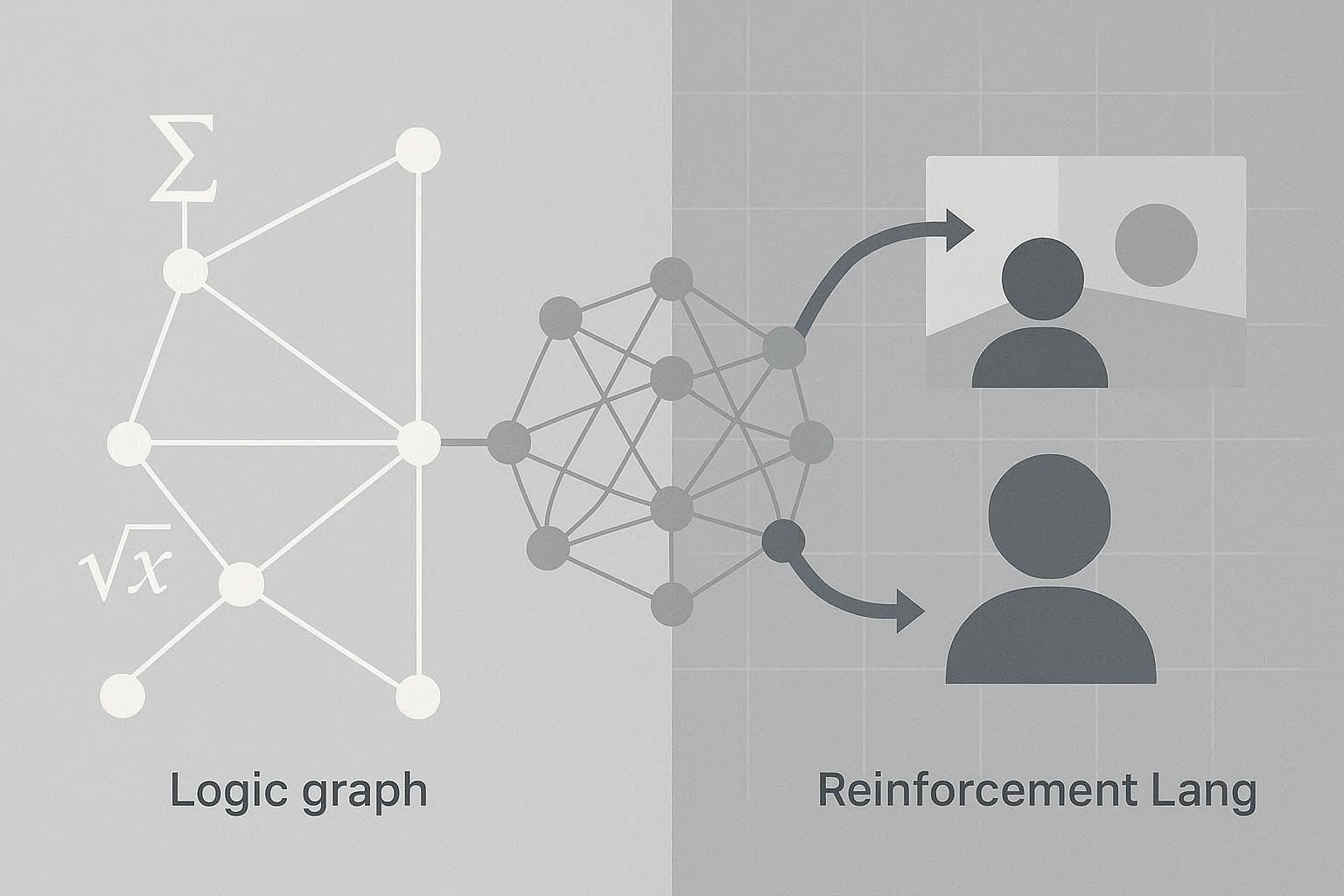

(1) 심볼릭 AI / 규칙 기반 시스템

논리 규칙과 지식 그래프 중심

장점: 확실한 추론, 예측 가능, 신뢰성 높음

단점: 유연성 부족, 자연어 생성 한계

(2) 강화학습 기반 에이전트

환경과 상호작용하며 행동 정책 학습

장점: 장기 계획, 최적화 문제, 게임·로봇 제어에 강점

단점: 대규모 자연어 처리에는 한계

(3) 뉴럴-심볼릭 통합 모델

LLM과 심볼릭 AI 결합을 넘어, 행동·지식·추론 통합

예: 실세계 로봇 제어, 복합 의사결정, 멀티모달 에이전트

즉, LLM만으로는 부족하며, 규칙 기반, 강화학습, 멀티모달 통합 모델 등으로 확장해야 실제 AI 에이전트·실무 적용 가능성이 높다.